人がモノを見たり想像したりする時の脳活動を解読、人工知能への応用も:京都大学 一般物体デコーディング

京都大学は、ヒトの脳活動パターンを人工知能モデルの信号に変換し、どんな物体を見たり想像したりしているかを脳から解読する技術を開発した。脳からビッグデータを利用する先進的技術となり、脳型人工知能の開発が期待できる。

京都大学は2017年5月22日、ヒトの脳活動パターンを人工知能モデルの信号に変換することで、見ている画像や想像している物体を脳から解読する技術を発表した。同大学 情報学研究科 教授の神谷之康氏、国際電気通信基礎技術研究所 主任研究員の堀川友慈氏の研究グループによるもので、成果は同日、英科学誌「Nature Communications」に掲載された。

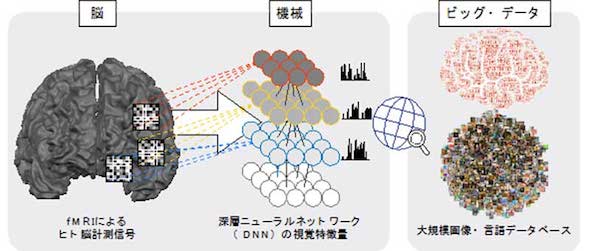

ヒトの脳活動パターンを機能的磁気共鳴画像法(fMRI)などによって計測し、機械学習によるパターン認識で解析すると、どんな物体を見たり想像したりしているかを予測できる。これは「ブレインデコーディング」と呼ばれ、同研究グループが世界に先駆けて開発してきた。

一方、深層ニューラルネットワーク(deep neural network model:DNN)は、脳のニューロンやシナプスにヒントを得て作られた人工ニューラルネットワークの一種で、近年ではヒトと同レベルの物体認識精度を達成している。

今回の研究では、これらと大規模画像データベースを組み合わせることで、モデルの学習に用いていない物体カテゴリーを含む、任意の物体カテゴリー情報を脳活動から予測する技術「一般物体デコーディング」を開発した。

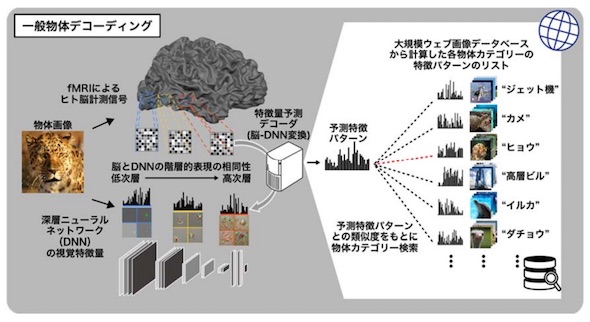

まず、物体画像をDNNの視覚特徴量パターンとして表現した。次に、ブレイン・デコーディングを応用して、被験者が物体画像を見ている時の脳活動パターンを基にDNNの信号を予測して脳からDNNに変換、DNN特徴デコーダーについて学習させた。

そして学習済みのDNN特徴デコーダーによって脳活動から予測された特徴パターンと、大規模画像データベースから得られる物体カテゴリーと視覚特徴パターンのリストを、類似度をもとにマッチングする。これにより、画像を見たり想像したりしている時の脳活動から、任意の物体カテゴリーの解読が可能になる。

このアプローチの有効性を検証するため、脳の視覚野の異なる部位の活動からデコーダーの学習を行ったところ、低次視覚野ではDNNの低次層の特徴量を、高次視覚野では高次層の特徴量を予測できた。同成果から脳とDNN間の相同性を確認した。

また、想像中の物体の視覚特徴が、実際に画像を見ている時と共通の脳活動パターンによって表現されていることが分かった。さらに、脳が高次から低次の順にトップダウン的に階層的特徴表現を活用している様子を可視化することにも成功。

そこで、1000個の物体カテゴリーから知覚/想像している物体カテゴリーを正しく予測できるかを検証すると、正解の物体カテゴリーが検索ランキングの上位に入った。予測が外れた場合も、正解のカテゴリーと意味的によく似たカテゴリーを予測できていた。

同成果は、人工知能モデルをヒトの脳と対応づけることで脳からビッグデータを利用する、先進的技術となる。そして、ブレインデコーディングへの応用だけでなく、脳型人工知能の開発にもつながることが期待される。

関連記事

視細胞を制御するソフトウェアを視覚再生医療に

視細胞を制御するソフトウェアを視覚再生医療に

JIG-SAWとモビコムは、ソフトウェアで視細胞を制御する「視覚再生医療」に着手した。視覚再生用のプリズムグラスと視細胞制御ソフトウェアを提供する。 ディープラーニングで胸部CT画像の読影を支援

ディープラーニングで胸部CT画像の読影を支援

東陽テクニカは、Riverain Technologiesの胸部CT血管透過・関心領域自動抽出ソフトウェア「ClearRead CT」の販売開始を発表した。 緑内障を自動分類するソフトウェア開発、米科学誌「PLOS ONE」に掲載

緑内障を自動分類するソフトウェア開発、米科学誌「PLOS ONE」に掲載

東北大学は、トプコンの技術本部と協力して、緑内障を自動で分類するソフトウェアを開発したと発表した。 体内の立体構造を正確に描出できる人工知能を用いた画像処理技術

体内の立体構造を正確に描出できる人工知能を用いた画像処理技術

富士フイルムは、患者ごとの体内の立体構造をより正確に描出できる、人工知能を用いた新たな画像処理技術を開発したと発表した。 生体レプリカの3Dプリントサービスと医療用3Dモデリングソフト

生体レプリカの3Dプリントサービスと医療用3Dモデリングソフト

武藤工業はアールテックと業務提携し、3Dプリンタによる生体模型出力サービスと医療用3Dモデリングソフトウェア「CMMed」の販売を開始した。

Copyright © ITmedia, Inc. All Rights Reserved.

会員登録がまだの方はこちら

豊富なホワイトペーパーの中から、製品・サービス導入の検討に役立つ技術情報や導入事例などを簡単に入手できます。

特集

- 設計者CAEの取り組みに関する実態

- マテリアルズ・インフォマティクスの動向調査

- 製造業のアナログ業務の実態調査

- 設計・解析業務におけるAI活用

- 製造現場におけるデータ活用の実態調査

- 3Dプリンタ利用動向調査

- CAD利用動向調査

- 研究・開発職のデジタル活用調査

- 安全安心なIoT機器実現の課題

- 電気設計者の課題と解決

- “つながる工場”の現状と課題

- 製造業におけるAI開発および活用の実態

- 設計・製造現場における品質管理

- 製造業IoTセキュリティ

- IoT時代の組み込みソフトウェア品質

- IoT時代のセキュリティリスクに備える

- 加速する工場と生産設備のデジタル化

- 製造業の省エネ対策と課題

- モノづくり設計者のワークスタイル調査

- タイアップ&セミナーコンテンツ一覧

脳−機械融合知能の概念図(クリックして拡大) 出典:京都大学

脳−機械融合知能の概念図(クリックして拡大) 出典:京都大学 一般物体デコーディングの概要図(クリックして拡大) 出典:京都大学

一般物体デコーディングの概要図(クリックして拡大) 出典:京都大学